- Blogs

- WordPress Seo

- Guía de robots.txt de WordPress: qué es y cómo usarlo

WordPress Seo / 9 min de lectura

Guía de robots.txt de WordPress: qué es y cómo usarlo

Si sos desarrollador o tenés experiencia trabajando con sitios web, probablemente hayas escuchado sobre un archivo llamado robots.txt.

robots.txt existe en la mayoría de los sitios web. Emite instrucciones para que los rastreadores de motores de búsqueda como el Googlebot de Google las sigan. Este archivo determina cuáles de las URLs de tu sitio web serán rastreadas e indexadas por los bots.

Aprender a optimizar el archivo robots.txt de tu sitio web es una excelente manera de mejorar la calificación de SEO general de tu sitio. Lo mejor de todo es que no necesitas tener un conocimiento profundo de desarrollo web para aprovechar sus beneficios.

Este artículo funcionará como una introducción a robots.txt. Vas a aprender:

- Qué es robots.txt y los beneficios de optimizarlo.

- Dónde se encuentra robots.txt en tu instalación de WordPress.

- Cómo editar robots.txt.

- Los comandos que podés emitir en robots.txt.

- Cómo verificar si robots.txt está funcionando como se espera.

- Las limitaciones de robots.txt.

Vamos a meternos de lleno.

¿Qué es el archivo robots.txt?

robots.txt es un archivo de texto disponible en las carpetas de tu sitio web. Desde el robots.txt, podés emitir comandos que les dicen a los rastreadores de motores de búsqueda qué recursos de tu sitio pueden acceder.

robots.txt te permite especificar qué directorios, subdirectorios, URLs o archivos no querés que los motores de búsqueda rastreen.

¿Cuáles son los beneficios de editar el archivo robots.txt de WordPress?

La razón principal para usar y optimizar robots.txt es aprovechar los beneficios de SEO. Un archivo robots.txt optimizado puede mejorar el posicionamiento general de SEO de tu sitio web.

Si no usás robots.txt, de forma predeterminada los bots pueden rastrear e indexar cada página de tu sitio web. Esto puede ser excelente para algunos, pero la mayoría de los sitios web tienen al menos algo de contenido duplicado, vacío u otros tipos de contenido no amigable para SEO.

Es una buena práctica evitar que estas páginas sean rastreadas y aparezcan en los resultados de búsqueda. Sin embargo, robots.txt no impide que el rastreador de Google (o cualquier otro) muestre las páginas de tu sitio web en los resultados de búsqueda. Incluso si bloqueás una página para que no sea rastreada mediante robots.txt, puede aparecer en los resultados de búsqueda si están enlazadas interna o externamente.

Si querés evitar que una página aparezca en los resultados de búsqueda, necesitás tanto desautorizarla en robots.txt como evitar manualmente que aparezca en las búsquedas usando un gestor de SEO como Yoast SEO.

Optimizar robots.txt ayudará a que los rastreadores web exploren tu sitio web de manera más eficiente, mejorando el SEO general de tu sitio.

Optimizar tu archivo robots.txt mejora tu presupuesto de rastreo

El presupuesto de rastreo es la cantidad de tiempo y recursos que un rastreador web dedica a tu sitio web. Cuanto mayor sea el presupuesto, más URLs explorará un rastreador web. Cuanto menor sea el presupuesto, menos URLs explorará.

Rastrear e indexar cuesta tiempo y potencia informática, ambos recursos limitados. Como resultado, querés que los rastreadores web exploren solo las páginas que querés impulsar en los motores de búsqueda y que ignoren todas las páginas que no querés impulsar.

Optimizar tu archivo robots.txt destacará contenido de alta calidad, reducirá la visibilidad de contenido de baja calidad (en términos de SEO) y evitará que los recursos de tu servidor se vean abrumados por demasiadas solicitudes.

Ahora que conocés lo básico del archivo robots.txt, avancemos a encontrarlo y editarlo.

¿Dónde está el archivo robots.txt de WordPress? ¿Cómo accedés a él?

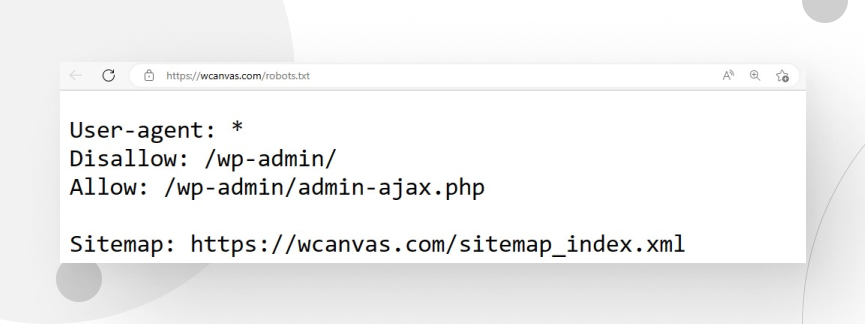

WordPress genera automáticamente el archivo robots.txt. Se encuentra en el dominio raíz de tu directorio, y podés encontrarlo ingresando a tu página de inicio y añadiendo “/robots.txt” al final de la URL. Por ejemplo, https://wcanvas.com/robots.txt.

Importante: Solo podés visualizar robots.txt en este directorio, no editarlo.

¿Cómo editar y optimizar robots.txt en WordPress?

Existen varias maneras de editar el archivo robots.txt. Nuestros desarrolladores siempre utilizan una de dos opciones: usar el plugin Yoast SEO o crear un archivo de texto llamado “robots” y subirlo al directorio raíz de WordPress.

Usando Yoast SEO

La forma más sencilla de editar el archivo robots.txt es mediante el uso de plugins. Nuestro plugin preferido para este propósito es Yoast SEO. El proceso es rápido y fácil.

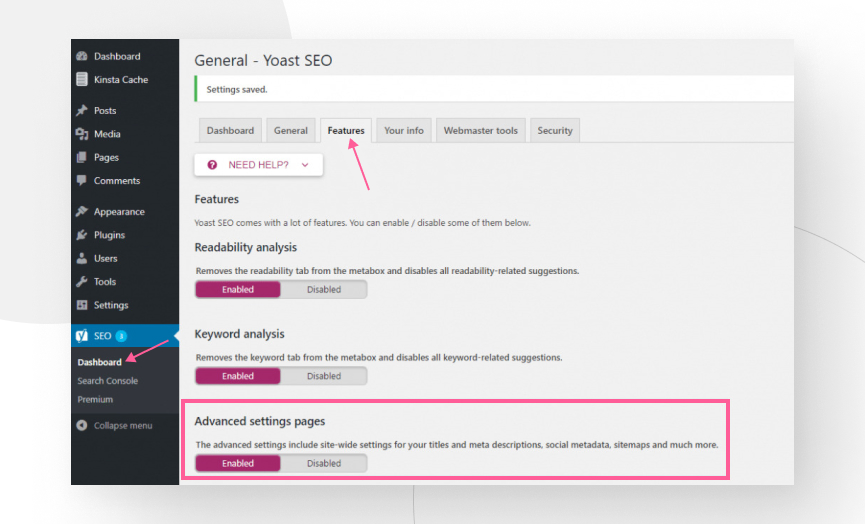

Primero, tenés que activar las funciones avanzadas del plugin. Podés hacerlo desde el panel de administración: Yoast SEO → Funciones. Una vez en la pestaña de funciones, activá la opción de Páginas de configuración avanzadas.

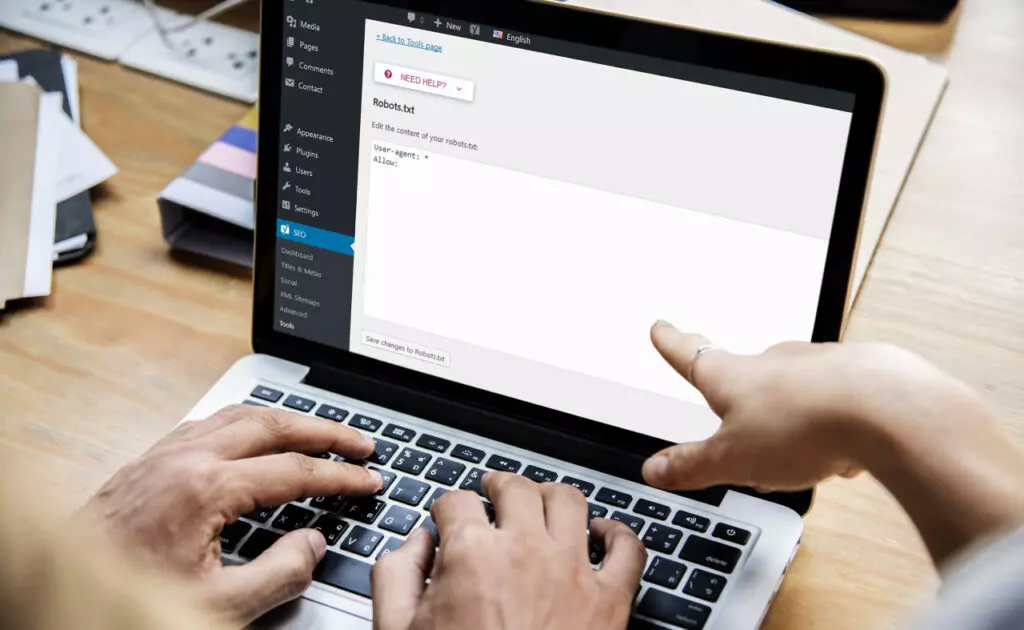

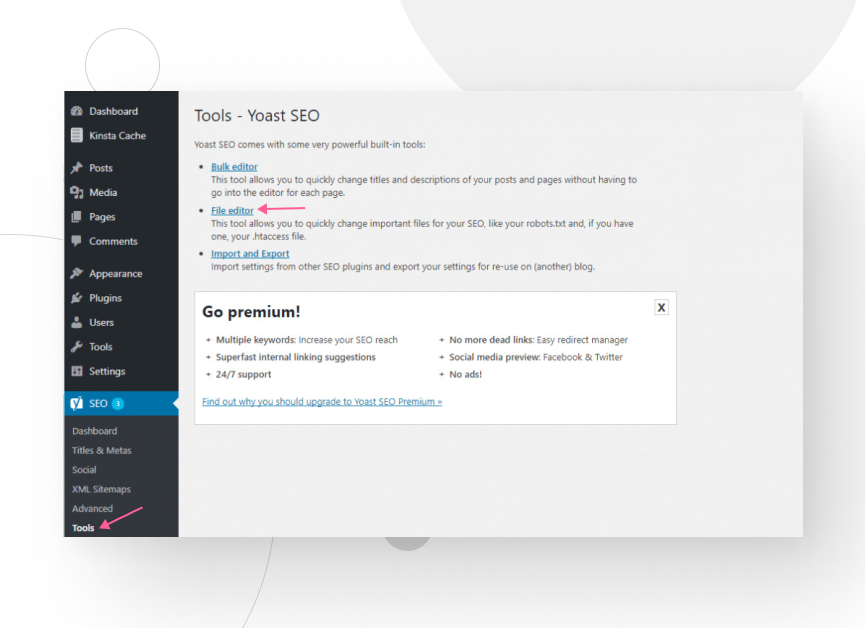

Una vez que hayas habilitado los ajustes avanzados, andá a Yoast SEO → Herramientas y clickeá en Editor de archivos.

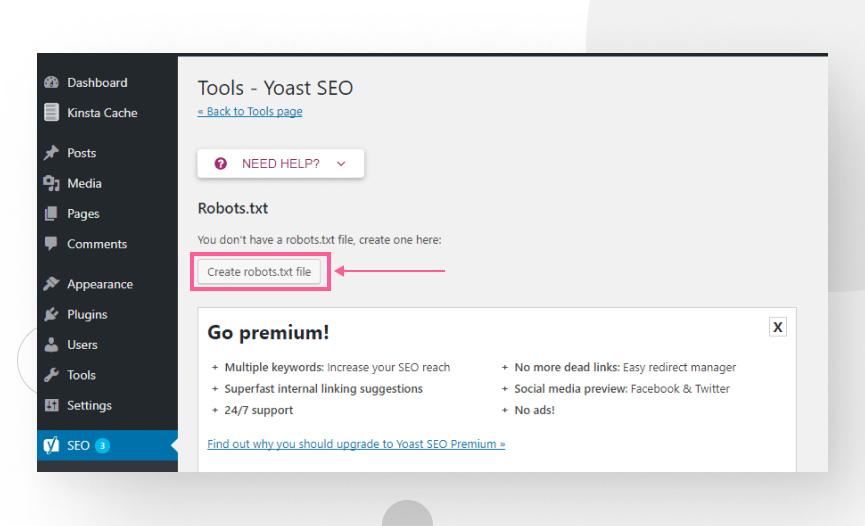

Tendrás la opción de crear un archivo robots.txt si no tenés uno ya.

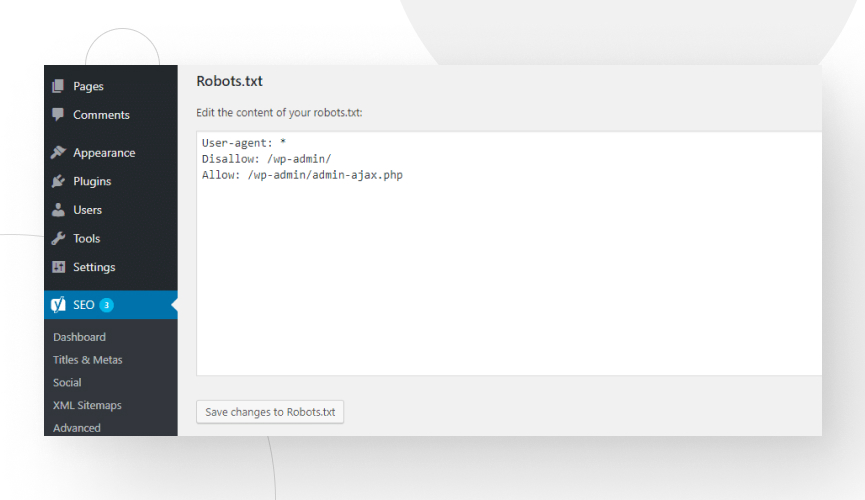

Ahora podés editar libremente robots.txt y guardar los cambios.

Creá un archivo “robots.txt” y subilo al directorio raíz de tu WordPress

En los raros casos en que no tuvimos acceso a Yoast SEO, creamos un archivo .txt llamado “robots” y lo subimos al directorio raíz de la instalación de WordPress.

Abrí cualquier editor de texto y creá un archivo con las directivas y sintaxis que deseás.

Usamos dos métodos principales para subirlo: el Administrador de Archivos en cPanel y aplicaciones FTP.

Subir robots.txt usando cPanel

- Accedé a tu Administrador de Archivos de cPanel y dirigite al directorio de instalación de WordPress, usualmente public_html.

- En la barra de herramientas superior, clickeá en Subir, y el archivo estará ahora en el directorio raíz.

Subir robots.txt usando FTP

- Conectáte al sitio web de tu sitio usando una aplicación FTP como FileZilla.

- Navegá hasta tu directorio raíz (de nuevo, será public_html).

- Simplemente arrastrá y soltá el archivo en el directorio raíz.

Comandos de robots.txt

El archivo robots.txt emite instrucciones para que los rastreadores sepan qué partes de tu sitio deben rastrear. Los tres comandos principales son:

- user-agent: se refiere al rastreador de los motores de búsqueda. El objetivo de tus comandos robots.txt es dirigir estos rastreadores. Podés emitir comandos dirigidos a rastreadores específicos o a todos los rastreadores.

- disallow: indica al agente de usuario no acceder, rastrear o indexar una URL, directorio o subdirectorio en particular.

- allow: opuesto a disallow. Indica que el contenido debe ser accesado, rastreado e indexado.

Recordá que los comandos de allow y disallow solo se aplicarán al agente de usuario especificado en la línea anterior a ellos. Se pueden incluir varias líneas de disallow para cada agente de usuario.

Comandos más usados en robots.txt

Indicaciones para un bot específico:

User-agent: [nombre del bot]

//Ejemplo

User-agent: GooglebotIndicaciones para todos los bots:

User-agent: *Agregá un asterisco (*). Cualquier comando bajo esta línea se aplica a todos los rastreadores que siguen los enlaces en tu sitio web.

Permitir el acceso total a todos los rastreadores:

User-agent: *

Disallow:De manera diferente, hacer esto sería no usar el archivo robots.txt o dejarlo vacío.

Bloquear todo el sitio web para que no sea rastreado e indexado usando un “/”:

Disallow: /Bloquear un directorio y su contenido:

Disallow: /nombre_del_directorio_aqui/Desautorizar una página web específica:

Disallow: /direccion_de_la_pagina_aquiBloquear todas las imágenes en el sitio web:

User-agent: *

Disallow: /Bloquear una imagen específica:

User-agent: Googlebot-Image

Disallow: /imagen/secreta.jpegDesautorizar un tipo de archivo específico:

User-agent: *

Disallow: /*.png$Ninguna imagen .png será rastreada e indexada.

Bloquear una secuencia de caracteres usando un asterisco:

User-agent:

Disallow: /directorio-secreto*/Bloquear URLs que terminan en un conjunto específico de caracteres agregando el símbolo “$” al final:

User-agent: *

Disallow: /*.pdfDesautorizar un bot específico:

User-agent: [nombre del bot]

Disallow: /Permitir el rastreo para un bot específico mientras bloquea a todos los demás:

User-agent: [nombre del bot]

Disallow:

User-agent: *

Disallow: /¿Cómo verificar si mi archivo robots.txt está funcionando correctamente para Google?

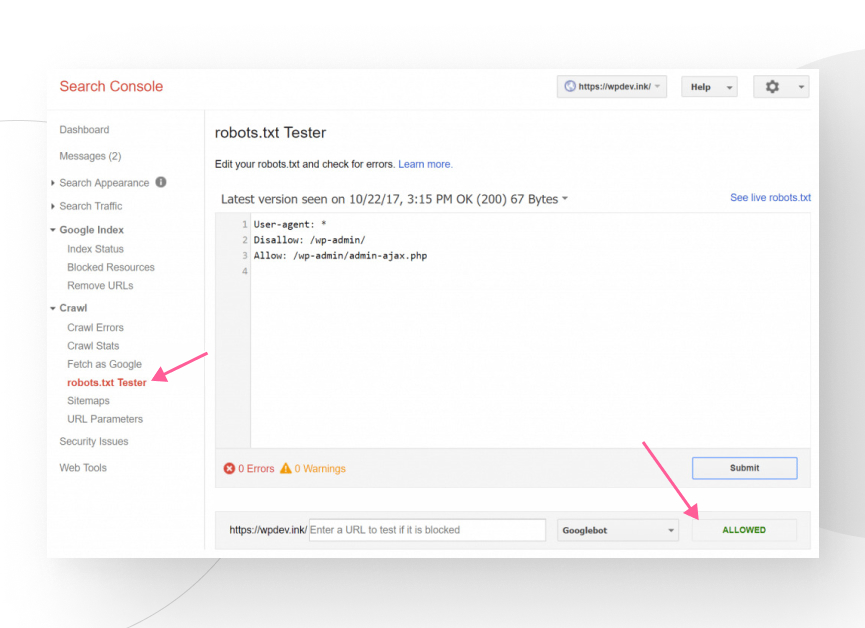

Podés verificar si tu archivo está configurado correctamente usando la herramienta de prueba de robots.txt en Google Search Console. Con esta prueba, podés ver cómo lo leerá Googlebot, permitiéndote detectar errores potenciales.

Para usar la herramienta, andá a Rastreo > Probador de robots.txt en el panel izquierdo de Google Search Console. Ingresá las URLs que querés probar en la barra inferior.

Te mostrará dos resultados: Permitido (la URL no está bloqueada) o Bloqueado (e indicará el comando que bloquea la URL).

Limitaciones del archivo robots.txt

Aunque este archivo puede ser muy útil para vos, también tiene algunas limitaciones que deberías conocer.

- Este archivo no garantiza que Google no indexe el contenido bloqueado ya que los motores de búsqueda descubren las páginas a través de enlaces. Si hay enlaces internos a las páginas bloqueadas, los bots probablemente las rastreen e indexen de todas formas. Deberías bloquear la indexación incluyendo una etiqueta noindex o proteger la página con contraseña para evitar la indexación.

- Diferentes rastreadores interpretan la sintaxis de robots.txt de diferentes maneras. La mayor atención se centra en Google, ya que es abrumadoramente popular. Sin embargo, puede ser necesario investigar cómo otros motores de búsqueda interactúan con robots.txt para optimizarlo para la mayor cantidad de motores posible.

- Algunos rastreadores pueden no seguir en absoluto los comandos en robots.txt.

Conclusiones

Si tenés contenido específico que querés que los rastreadores eviten o excluyan de los resultados de búsqueda, vale la pena dedicar tiempo a configurar los comandos apropiados en el archivo robots.txt de tu sitio web.

El beneficio último de optimizar tu archivo robots.txt es mejorar tu presupuesto de rastreo. Al evitar que los bots rastreen e indexen publicaciones y páginas específicas, asegurás que los motores de búsqueda tengan suficientes recursos para todas las páginas que querés impulsar.

Finalmente, recordá que, aunque (la mayoría) de los rastreadores seguirán las indicaciones de tu archivo, esto no garantiza que el contenido no pueda ser indexado por otros medios. Si querés que una página específica quede fuera de los resultados de búsqueda, usá la etiqueta noindex en su lugar.

Si encontraste útil este artículo, visitá nuestro blog para más ideas y guías de WordPress.

Related Articles

WordPress Seo / 4 min de lectura

WordPress Seo / 4 min de lectura

Cómo desactivar el indexado de Google en un sitio de WordPress

Ya sea que quieras que tu sitio web solo por invitación se mantenga privado o que estés probando tus habilidades de desarrollo web y quieras evitar el tráfico, hay varias…

Read More

WordPress Seo / 14 min de lectura

WordPress Seo / 14 min de lectura

¿Qué es un consultor de SEO para WordPress?

Un consultor de SEO para WordPress es una agencia especializada en optimizar el SEO de tu sitio web para ayudarte a atraer más tráfico orgánico y volverte más relevante en…

Read More

Paso a paso / 13 min de lectura

Paso a paso / 13 min de lectura

Cómo configurar y utilizar Link Whisper en WordPress

Link Whisper es un plugin de WordPress que facilita y acelera la creación de enlaces internos al ofrecer sugerencias impulsadas por inteligencia artificial, basadas en un escaneo de todo el…

Read More

Paso a paso / 7 min de lectura

Paso a paso / 7 min de lectura

Cómo gestionar las etiquetas Noindex en WordPress con Yoast SEO

Gestionar las etiquetas noindex en WordPress es uno de los ajustes de SEO más comunes que realizan los administradores, propietarios y desarrolladores. Si bien es posible editar el HTML de…

Read More

Paso a paso / 11 min de lectura

Paso a paso / 11 min de lectura

Yoast SEO para WordPress sin cabeza: cómo configurarlo con GraphQL y Next.js

Como muchos desarrolladores de WordPress headless saben, mejorar el SEO del frontend de tu sitio es muy desafiante cuando se utilizan ciertos frameworks de frontend, como React. Pero en la…

Read More